Ein Update zu der etwas in die Jahre gekommenen Anleitung zur Installation von Etherpad Lite auf Ubuntu, auch wenn sich viele Dinge nicht wirklich grundlegend geändert haben.

Erst einmal versorgen wir unseren Server mit einem aktuellen NodeJ.js sowie NPM. Die Anleitung hierzu: https://nodejs.org/en/download/package-manager/#debian-and-ubuntu-based-linux-distributions

Dieser wird gefolgt, bis mit

sudo apt-get install -y nodejs

nicht nur NodeJS, sondern auch NPM an Bord ist.

Es folgen die Vorbereitungen für die lokale Installation von EP:

apt-get install gzip git curl python libssl-dev pkg-config build-essential

Dazu gehört ein Benutzerkonto etherpad:

sudo adduser --system --home=/opt/etherpad --group etherpad

In dessen Kontext dann gewechselt wird, um EP zu installieren:

sudo su - etherpad -s /bin/bash

# Dann als User etherpad weiter

git clone git://github.com/ether/etherpad-lite.git

cd etherpad-lite

bin/run.sh

Der erste Start installiert die Abhängigkeiten und sollte es danach ermöglichen, die Etherpad Installation unter http://example.org:9001 aufzurufen. Gelingt dies, dann brechen wir EP mit STRG C ab, um in Ruhe die Datei settings.json in /opt/etherpad/etherpad-lite sowie den Web- und DB-Server anzupassen.

Da wir nun immer wieder EP neu starten (als user etherpad) und außerdem als root weitere Pakete nachinstallieren sowie Anpassungen vornehmen müssen macht eine zweite Shell zum Server Sinn.

Nach der Installation von Apache2 und der Einrichtung von SSL-Zertifikaten folgt die Aktivierung der entsprechenden Module im Apachen:

a2enmod proxy proxy_http deflate headers ssl wstunnel

Ich folge hier im Wesentlichen der Anleitung hier: https://github.com/ether/etherpad-lite/wiki/How-to-put-Etherpad-Lite-behind-a-reverse-Proxy und erhalte am Ende eine VirtualHost Definition, die so aussieht:

<VirtualHost *:443>

ServerAdmin webmaster@example.com

ServerName etherpad.example.com

DocumentRoot /var/www/example.com

SSLEngine on

ServerSignature On

SSLHonorCipherOrder on

SSLCipherSuite ECDH+AESGCM:DH+AESGCM:ECDH+AES256:DH+AES256:ECDH+AES128:DH+AES:ECDH+3DES:DH+3DES:RSA+AESGCM:RSA+AES:RSA+3DES:!aNULL:!MD5:!DSS

SSLCertificateFile /etc/letsencrypt/live/example.com/cert.pem

SSLCertificateChainFile /etc/letsencrypt/live/example.com/chain.pem

SSLCertificateKeyFile /etc/letsencrypt/live/example.com/privkey.pem

ProxyVia On

ProxyRequests Off

ProxyPreserveHost on

<Location />

ProxyPass http://localhost:9001/ retry=0 timeout=30

ProxyPassReverse http://localhost:9001/

</Location>

<Location /socket.io>

RewriteEngine On

RewriteCond %{QUERY_STRING} transport=websocket [NC]

RewriteRule /(.*) ws://localhost:9001/socket.io/$1 [P,L]

ProxyPass http://localhost:9001/socket.io retry=0 timeout=30

ProxyPassReverse http://localhost:9001/socket.io

</Location>

<Proxy *>

Options FollowSymLinks MultiViews

AllowOverride All

Order allow,deny

allow from all

</Proxy>

# Available loglevels: trace8, ..., trace1, debug, info, notice, warn,

# error, crit, alert, emerg.

# It is also possible to configure the loglevel for particular

# modules, e.g.

#LogLevel info ssl:warn

ErrorLog ${APACHE_LOG_DIR}/error.log

CustomLog ${APACHE_LOG_DIR}/access.log combined

#SSLOptions +FakeBasicAuth +ExportCertData +StrictRequire

<FilesMatch "\.(cgi|shtml|phtml|php)$">

SSLOptions +StdEnvVars

</FilesMatch>

<Directory /usr/lib/cgi-bin>

SSLOptions +StdEnvVars

</Directory>

</VirtualHost>

Nach einem Neustart des Apachen und einem erneuten Start von EP lite (aus dem Konto von etherpad heraus) sollte EP über https abgerufen werden können.

Hinweis zu den geladenen Apache-Modulen: wstunnel beseitigte bei mir Fehlermeldungen wie die diese:

[proxy:error] [pid 7926] [client 79.1.8.45:40652] AH00898: Error reading from remote server returned by /socket.io/

[proxy:warn] [pid 7934] [client 79.1.8.45:40848] AH01144: No protocol handler was valid for the URL /socket.io/. If you are using a DSO version of mod_proxy, make sure the proxy submodules are included in the configuration using LoadModule.

Wir können EP nun wieder mit STRG C anhalten und eine Datenbank für EP einrichten. Dazu benötigen wir einen MySQL-Server sowie, bei Bedarf, phpMyAdmin für die einfachere Verwaltung. Weiter sollte auch abiword mit an Bord geholt werden, damit Pads exportiert werden können.

Sind diese Schritte vollbracht, wird die settings.json überarbeitet:

/*

This file must be valid JSON. But comments are allowed

Please edit settings.json, not settings.json.template

To still commit settings without credentials you can

store any credential settings in credentials.json

*/

{

// Name your instance!

"title": "KvFG Etherpad",

// favicon default name

// alternatively, set up a fully specified Url to your own favicon

"favicon": "favicon.ico",

//IP and port which etherpad should bind at

"ip": "0.0.0.0",

"port" : 9001,

// Option to hide/show the settings.json in admin page, default option is set to true

"showSettingsInAdminPage" : true,

/*

// Node native SSL support

// this is disabled by default

//

// make sure to have the minimum and correct file access permissions set

// so that the Etherpad server can access them

"ssl" : {

"key" : "/path-to-your/epl-server.key",

"cert" : "/path-to-your/epl-server.crt",

"ca": ["/path-to-your/epl-intermediate-cert1.crt", "/path-to-your/epl-intermediate-cert2.crt"]

},

*/

//The Type of the database. You can choose between dirty, postgres, sqlite and mysql

//You shouldn't use "dirty" for for anything else than testing or development

"dbType" : "mysql",

"dbSettings" : {

"user" : "dbname",

"host" : "localhost",

"password": "dbpassword",

"database": "dbuser",

"charset" : "utf8mb4"

},

//the default text of a pad

"defaultPadText" : "Welcome to Etherpad on Karlo!\n\nMit der Nutzung dieser Etherpad-Installation erklaerst Du Dich mit den folgenden Bedingungen einverstanden: https://example.com/doku.php?id=etherpad\n",

/* Default Pad behavior, users can override by changing */

"padOptions": {

"noColors": false,

"showControls": true,

"showChat": true,

"showLineNumbers": true,

"useMonospaceFont": false,

"userName": false,

"userColor": false,

"rtl": false,

"alwaysShowChat": false,

"chatAndUsers": false,

"lang": "de"

},

/* Pad Shortcut Keys */

"padShortcutEnabled" : {

"altF9" : true, /* focus on the File Menu and/or editbar */

"altC" : true, /* focus on the Chat window */

"cmdShift2" : true, /* shows a gritter popup showing a line author */

"delete" : true,

"return" : true,

"esc" : true, /* in mozilla versions 14-19 avoid reconnecting pad */

"cmdS" : true, /* save a revision */

"tab" : true, /* indent */

"cmdZ" : true, /* undo/redo */

"cmdY" : true, /* redo */

"cmdI" : true, /* italic */

"cmdB" : true, /* bold */

"cmdU" : true, /* underline */

"cmd5" : true, /* strike through */

"cmdShiftL" : true, /* unordered list */

"cmdShiftN" : true, /* ordered list */

"cmdShift1" : true, /* ordered list */

"cmdShiftC" : true, /* clear authorship */

"cmdH" : true, /* backspace */

"ctrlHome" : true, /* scroll to top of pad */

"pageUp" : true,

"pageDown" : true

},

/* Should we suppress errors from being visible in the default Pad Text? */

"suppressErrorsInPadText" : false,

/* Users must have a session to access pads. This effectively allows only group pads to be accessed. */

"requireSession" : false,

/* Users may edit pads but not create new ones. Pad creation is only via the API. This applies both to group pads and regular pads. */

"editOnly" : false,

/* Users, who have a valid session, automatically get granted access to password protected pads */

"sessionNoPassword" : false,

/* if true, all css & js will be minified before sending to the client. This will improve the loading performance massivly,

but makes it impossible to debug the javascript/css */

"minify" : true,

/* How long may clients use served javascript code (in seconds)? Without versioning this

may cause problems during deployment. Set to 0 to disable caching */

"maxAge" : 21600, // 60 * 60 * 6 = 6 hours

/* This is the absolute path to the Abiword executable. Setting it to null, disables abiword.

Abiword is needed to advanced import/export features of pads*/

"abiword" : "/usr/bin/abiword",

/* This is the absolute path to the soffice executable. Setting it to null, disables LibreOffice exporting.

LibreOffice can be used in lieu of Abiword to export pads */

"soffice" : null,

/* This is the path to the Tidy executable. Setting it to null, disables Tidy.

Tidy is used to improve the quality of exported pads*/

"tidyHtml" : null,

/* Allow import of file types other than the supported types: txt, doc, docx, rtf, odt, html & htm */

"allowUnknownFileEnds" : true,

/* This setting is used if you require authentication of all users.

Note: /admin always requires authentication. */

"requireAuthentication" : false,

/* Require authorization by a module, or a user with is_admin set, see below. */

"requireAuthorization" : false,

/*when you use NginX or another proxy/ load-balancer set this to true*/

"trustProxy" : false,

/* Privacy: disable IP logging */

"disableIPlogging" : false,

/* Time (in seconds) to automatically reconnect pad when a "Force reconnect"

message is shown to user. Set to 0 to disable automatic reconnection */

"automaticReconnectionTimeout" : 0,

/* Users for basic authentication. is_admin = true gives access to /admin.

If you do not uncomment this, /admin will not be available! */

"users": {

"admin": {

"password": "adminpassword",

"is_admin": true

},

"user": {

"password": "changeme1",

"is_admin": false

}

},

// restrict socket.io transport methods

"socketTransportProtocols" : ["xhr-polling", "jsonp-polling", "htmlfile"],

// Allow Load Testing tools to hit the Etherpad Instance. Warning this will disable security on the instance.

"loadTest": false,

// Disable indentation on new line when previous line ends with some special chars (':', '[', '(', '{')

/*

"indentationOnNewLine": false,

*/

/* The toolbar buttons configuration.

"toolbar": {

"left": [

["bold", "italic", "underline", "strikethrough"],

["orderedlist", "unorderedlist", "indent", "outdent"],

["undo", "redo"],

["clearauthorship"]

],

"right": [

["importexport", "timeslider", "savedrevision"],

["settings", "embed"],

["showusers"]

],

"timeslider": [

["timeslider_export", "timeslider_returnToPad"]

]

},

*/

/* The log level we are using, can be: DEBUG, INFO, WARN, ERROR */

"loglevel": "INFO",

//Logging configuration. See log4js documentation for further information

// https://github.com/nomiddlename/log4js-node

// You can add as many appenders as you want here:

"logconfig" :

{ "appenders": [

{ "type": "console"

//, "category": "access"// only logs pad access

}

/*

, { "type": "file"

, "filename": "your-log-file-here.log"

, "maxLogSize": 1024

, "backups": 3 // how many log files there're gonna be at max

//, "category": "test" // only log a specific category

}*/

/*

, { "type": "logLevelFilter"

, "level": "warn" // filters out all log messages that have a lower level than "error"

, "appender":

{ Use whatever appender you want here }

}*/

/*

, { "type": "logLevelFilter"

, "level": "error" // filters out all log messages that have a lower level than "error"

, "appender":

{ "type": "smtp"

, "subject": "An error occurred in your EPL instance!"

, "recipients": "bar@blurdybloop.com, baz@blurdybloop.com"

, "sendInterval": 300 // 60 * 5 = 5 minutes -- will buffer log messages; set to 0 to send a mail for every message

, "transport": "SMTP", "SMTP": { // see https://github.com/andris9/Nodemailer#possible-transport-methods

"host": "smtp.example.com", "port": 465,

"secureConnection": true,

"auth": {

"user": "foo@example.com",

"pass": "bar_foo"

}

}

}

}*/

]

}

}

Viel angepasst habe ich nicht: Die Datenbankverbindung, den einführenden Text in jedes Pad mit einem Verweis auf die Benutzerordnung und das Passwort für den administrativen Benutzer.

Ob die Datenbankverbindung glückt, wird erneut aus dem Kontext des Benutzers etherpad geprüft. Danach wird Etherpad als Service eingerichtet.

Dazu erstellt man sich eine Datei /etc/systemd/system/etherpad.service mit folgendem Inhalt:

[Unit]

Description=Etherpad

After=syslog.target network.target

[Service]

Type=simple

User=etherpad

Group=etherpad

WorkingDirectory=/opt/etherpad/etherpad-lite

ExecStart=/usr/bin/nodejs /opt/etherpad/etherpad-lite/node_modules/ep_etherpad-lite/node/server.js

Restart=always

[Install]

WantedBy=multi-user.target

Das entspricht bis auf die Pfade der Anleitung hier: https://github.com/ether/etherpad-lite/wiki/How-to-deploy-Etherpad-Lite-as-a-service

Gelingt der Start mit service etherpad start kann man mit ufw den Port 9001 zu machen und in den Betrieb übergehen. Wer will kann etherpad auch automatisch starten lassen: systemctl enable etherpad

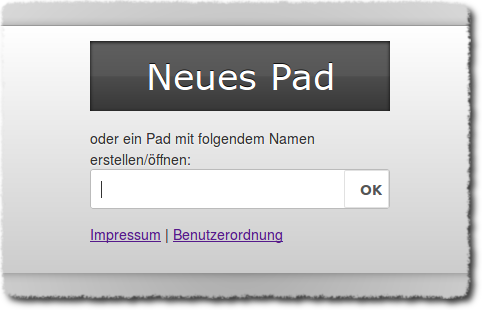

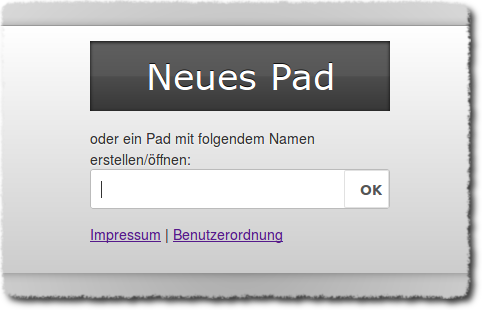

Der Login-Screen von Etherpad kann in /opt/etherpad/etherpad-lite/src/templates/index.html an die eigenen Wünsche angepasst und z.B. um Links zum Impressum und zur Benutzerordnung erweitert werden.

# ca ab Zeile 160

<div id="wrapper">

<% e.begin_block("indexWrapper"); %>

<div id="inner">

<button id="button" onclick="go2Random()" data-l10n-id="index.newPad"></button>

<label id="label" for="padname" data-l10n-id="index.createOpenPad"></label>

<form action="#" onsubmit="go2Name();return false;">

<input type="text" id="padname" maxlength="50" autofocus x-webkit-speech>

<button type="submit">OK</button>

</form>

<p><a href="https://link.zum.impressum" target="_blank">Impressum</a> | <a href="https://link.zur.nutzungsordnung" target="_blank">Benutzerordnung</a></ p>

</div>

Nur noch ein Punkt: Das Plugin, das man als schulischer Admin unbedingt haben will, ist das hier: https://www.npmjs.com/package/ep_adminpads